Bases de données

Bases de données jppCe chapitre regroupe différents articles sur les bases de données (très connues ou moins connues) :

- Installation

- Usage

- Petits ennuis

- ....

Table de test : description

Table de test : description jppNote 2022 : il faudra que je crée une table plus volumineuse pour faire ce type de tests avec au moins 2 ou 3 millions de rangs, mais en 2010 les disques étaient plus petits, plus chers et nettement moins rapides qu'un SSD moderne.

Pour de très gros tests (par exemple ClickHouse) je dispose d'une bonne grosse table de plus de 600 millions de rangs (#200Go sur disque).

Afin de "tester" un peu le fonctionnement des bases de données avec une table un peu "lourde" qui oblige le moteur à "sortir de ses caches". Le cache des données doit être positionné à une valeur de l'ordre de 256 Mo. J'utilise une table statistique de l'activité des machines virtuelles. Cette table comporte environ 300 000 lignes et est donc très insuffisante en volume.

| create table xen_stat_v2 ( DATEC varchar(10), HEUREC varchar(5), SERVEUR varchar(16), DOMNOM varchar(16), DELTACPU decimal, DELTARX decimal, DELTATX decimal, CPUPCT decimal, NBSECR decimal, NBSECW decimal ) |

La syntaxe du "CREATE TABLE" est à adapter légèrement selon la BDD cible.

Cette table comporte, outre l'heure (HEUREC au format HH:MM), une colonne "DATEC" au format AAAAMMJJLa procédure de "gonflage" consiste donc à :

- Calculer la différence entre les dates (AAAAMMJJ) mini et maxi sur la table permanente

- Créer une nouvelle table de travail avec une date = (date originale) - différence calculée en (1) par un select sur la table originale.

- Insérer cette nouvelle table dans la table originale

- Et on recommence autant de fois qu'il faut pour dépasser les 13 millions de lignes. Là aussi la syntaxe est à adapter selon la base cible ...

Les opérations mesurées ensuite sont :

La création de deux index :

create index xen_stat_v2_i1 on xen_stat_v2 (DOMNOM, DATEC, HEUREC)

create index xen_stat_v2_i2 on xen_stat_v2 (DATEC, DOMNOM, HEUREC)

Le calcul des statistiques sur cette table :

Lancement de quelques "select" donnant des totaux avec un group by / order by :

|

select count(*) select DOMNOM,count(*) select DOMNOM,SERVEUR,count(*) |

Ces quelques opérations donnent simplement un petit avant-goût de la performance globale.

Petits ennuis

Petits ennuis jppUn petit chapitre sur quelques "ennuis".

MariaDB binlog non supprimés !

MariaDB binlog non supprimés ! jppUn petit ennui : les fichiers "binlog" ne sont plus supprimés malgré la présence du paramètre adéquat : expire_logs_days = 3

Ce phénomène m'a été montré par l'augmentation anormale de la taille de la partition qui supporte ces fichiers et son approche des 100% fatidiques.

Après quelques recherches sur Internet je ne trouve rien à ce sujet.

J'essaye de purger ces fichus binlog avec la commande "purge binlog until '2022-06-14' " ou "purge binlog to '0000xxxxxxxxxx' ".

Ces commandes me répondent invariablement "fichier log non trouvé dans l'index" .... ???? ....

J'allais me résoudre à une manip hasardeuse de destruction "manuelle avec rm ..." et mise à jour du fichier d'index, lorsque j'ai remarqué que le fichier index, "mysql-binlog.index" chez moi, comportait une ligne blanche en tête.

Je stoppe MariaDB et supprime cette fichue ligne "blanche" et, miracle, lors du redémarrage de MariaDB tous les vieux binlog disparaissent en respectant bien la limite à trois jours et la partition revient à un pourcentage et un nombre de fichiers bien plus sympathique.

Depuis 2 jours tout est normal et aucun fichier ne date de plus de 3 jours .... le problème semble donc réglé.

Mysql se plante inopinément

Mysql se plante inopinément jppJ'ai eu récemment un plantage violent de Mysql suite à une mise à jour d'une Debian 9. Le process Mysql avait une fâcheuse tendance à consommer tout le CPU et manifestait son mécontentement par de nombreux messages, le total fait plus de 4000 lignes, j'en ai extrait les parties les plus typiques :

|

InnoDB: Warning: a long semaphore wait: key_buffer_size=524288 Thread pointer: 0x0 |

J'ai commencé par copier l'intégralité des fichiers de la base sur un autre disque afin de préserver leur état.

Après recherche sur Internet et plusieurs essais de redémarrage infructueux, y compris par l'utilisation de "innodb_force_recovery = 1".

J'ai alors songé à examiner le syslog et j'y ai trouvé de nombreux messages tels que :

| ....apparmor="DENIED" operation="open" profile="/usr/sbin/mysqld" name="/MYSQL_DATA/mysql/" pid=4690 comm="mysqld" requested_mask="r" denied_mask="r" |

Note : chez moi les données de Mysql sont stockées dans une partition spécifique (sur SSD) montée sur /MYSQL_DATA/mysql.

J'ai alors cherché un fichier "usr.sbin.mysqld", vainement, dans /etc/apparmor.d, aucune trace d'un tel fichier !

Je n'ai pas pu trouver l'origine de cette disparition, probablement la dernière mise à jour et j'ai du récupérer ce fichier "usr.sbin.mysqld" et son copain dans "/etc/apparmor.d/local" sur une autre machine et le personnaliser à nouveau car cette base utilise une partition séparée ...

J'ai aussi voulu mettre apparmor en mode "complain" pour mysqld mais je me suis aperçu que le paquet "apparmor-utils" qui contient, entre autres, la fonction "aa-complain" qui permet de gérer cela brillait par son absence, j'ai donc du installer ce paquet pour placer /usr/sbin/mysqld en mode "complain" en attendant d'analyser les données fournies par les logs.

Ensuite Mysql a démarré sans encombres et fonctionne normalement depuis.

En fait les messages de Mysql sont le reflet des erreurs induites par les blocages effectués par Apparmor suite à l'absence (inexpliquée à ce jour d'un fichier de paramétrage de Apparmor) et non dus à un dysfonctionnement de Mysql ou d'un problème système quelconque (librairies, disque ....).

Enfin ce type d'erreur est de plus en plus rare, les "paquets" sont, en général, bien configurés coté "apparmor".

Mysql : refus demarrage

Mysql : refus demarrage jppJuste avant de partir une semaine en congés, j'ai effectué une mise à jour du système qui "supporte", entre autres choses, la machine virtuelle (KVM) de ce site, j'ai eu le malheur de ré-démarrer le machine, petit nettoyage de la mémoire avant de partir ...

Je n'ai pas vérifié que tout se passait bien au redémarrage et, quelques heures après en consultant mes mails j'ai constaté que la base de données de ce système était inaccessible et que certains logiciels ne fonctionnaient plus car ils utilisent cette base Mysql ...

Dans le coin où j'étais en congés les liaisons téléphoniques étaient tellement mauvaises que je n'ai pas pu prendre la main à distance pour étudier ce phénomène. J'ai du attendre le retour pour me pencher sur cet ennui.

Mysql ne se lançait plus et, comme d'habitude, les renseignements fournis par systemd étaient insuffisants pour toute analyse sérieuse : le service a retourné une erreur ... ce n'est pas très informatif sur la nature de l'erreur et donc franchement inutile !

Une erreur c'est bien de le savoir, mais il serait mieux de savoir laquelle en ayant un message sensé aidant à comprendre le pourquoi !

En lançant Mysql "à la main" en tant qu'utilisateur "mysql" (il faut modifier le shell de démarrage dans /etc/password de /bin/false à /bin/bash) j'ai tout de suite eu un message "fichier my.cnf inexistant", ce qui était beaucoup plus clair que "le service a retourné une erreur'. Ne pas oublier de repasser cet utilisateur à "/bin/false" après la manip !

Je me précipite dans /etc/mysql et ... le fichier "my.cnf" est présent sous la forme d'un lien vers /etc/alternatives/my.cnf", or en tentant de le lister j'obtiens un message de fichier inexistant ... et dans /etc/alternatives il existe bien un fichier "my.cnf" mais sous la forme d'un lien vers /etc/mysql/my.cnf !!!

Je crée donc un "vrai" fichier "my.cnf" contenant :

[mysqld]

!includedir /etc/mysql/mysql.conf.d/

Et systemd lance la base de données sans aucun message alarmant, mais je ne saurais jamais comment et par qui ce lien "en boucle" a été mis en place.

Bases à découvrir

Bases à découvrir jppCe groupe d'articles est destiné à présenter des bases de données moins connues que Oracle ou Mysql mais qui possèdent une implantation industrielle assez importante et qui pour certaines existent depuis très longtemps. Nous allons commencer cette petite série par deux bases à l'historique important.

-

Sybase

Base de données fort ancienne qui en est à la version 15. Sybase a donné naissance à un "fork" fort connu : SqlServer auquel Microsoft a assuré une forte visibilité. SqlServer présente de nombreuses analogies avec Sybase et jusque il n'y a pas bien longtemps (je n'ai pas vérifié depuis) il existait une certaine compatibilité.

Le langage procédural utilisé "Tsql" reste compatible pour tous les ordres "simples", et les langages SQL sont très semblables. -

Ingres

C'est aussi une base de données ancienne qui a connu de fortes vicissitudes au cours de son existence, la société avait été rachetée par un des grands du logiciel professionnel : CA qui l'a conservée pendant de nombreuses années sans lui assurer une forte diffusion et a fini par mettre le logiciel plus ou moins en Open Source. Aujourd'hui le développement continue au sein de la société Actian dans les versions "Community" aussi bien que dans les versions "Entreprise" avec support. - Clickhouse

Cette base semble très rapide et donc intéressante à tester.

Cette base semble très rapide et donc intéressante à tester.

Ingres

Ingres jppDans ce chapitre je vais essayer de présenter la base de données Ingres (prononcer INGRESS ! pour faire américain) avec son inévitable installation dans la version 10 OpenSource.

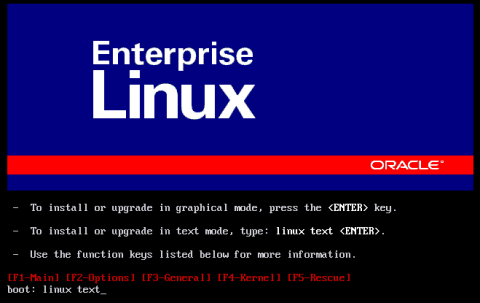

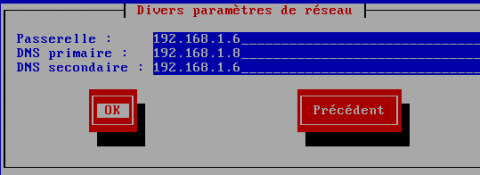

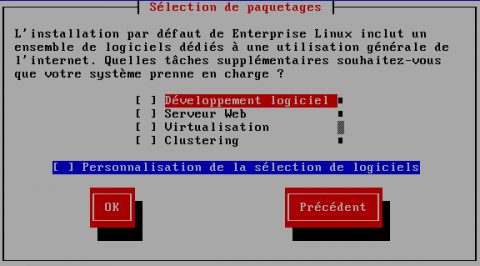

L'installation sera réalisée sur une machine virtuelle (Centos-5.4 64bits sous KVM) dont l'installation est détaillée dans un autre article.

Afin de rester dans des "normes" raisonnable une configuration analogue à celle utilisée pour Oracle 10g et Sybase 15 est utilisée, pour mémoire elle est constituée de :

- 1 CPU

- 1536 Mo de RAM

- 3 disques de 16 Go

- un pour le système

- un pour les données

- un pour les log et les espaces temporaires

Les disques sont de "simples" partitions LVM sur un ensemble de disques montés en miroir (deux miroirs différents pour données et log).

Cette configuration permettra de faire quelques comparaisons avec le mini-test défini dans cet article.

La machine physique est différente mais sur un seul processeur c'est en gros équivalent (2,4Ghz contre 2,6).

Ingres : installer (1)

Ingres : installer (1) jppPré-requis : Après l'installation du système il est nécessaire (sauf si vous avez chosi KDE) d'installer KDEbase afin de disposer de "konsole", l'explication est toute simple : seul le terminal "konsole" de KDE permet, à ma connaissance, d'avoir le rendu "semi-graphique" utilisé par les outils Ingres, et surtout d'avoir accès aux "bonnes" touches de fonction exploitées par tous les outils de configuration de Ingres.

J'installe aussi mon éditeur préféré "yum install vim-X11".

Le logiciel a été téléchargé et installé dans /var/tmp/INSTALL :

- ingres-10.0.0-122-NTPL-gpl-linux-ingbuild-x86_64.tgz (#60 Mo)

Le "détarage" du fichier crée un répertoire du même nom comprenant :

-rwxr-xr-x 1 ingres 50000 17847 avr 21 19:10 ingres_express_install.sh

-rw-rw-r-- 1 ingres 50000 78571520 avr 21 19:50 ingres.tar

-rwxr-xr-x 1 ingres 50000 13299 avr 21 19:10 install.sh

-rw-r--r-- 1 ingres 50000 15238 avr 21 19:02 LICENSE

-rw-r--r-- 1 ingres 50000 10636 avr 21 19:29 readme_a64_lnx_nptl.html

-rw-rw-r-- 1 ingres 50000 28075 avr 21 19:29 readme.html

L'installation étant parfois en mode texte, parfois en mode semi-graphique je vais essayer de "rendre" au mieux l'aspect des écrans, donc ici pas de belles images, que du texte !

Je me connecte dans une session X avec le user "root" (c'est comme cela depuis la version 2006r3) pour lancer l'installation dans une "konsole".

Ne pas lancer le tentant "ingres_express_install.sh" car il ne réalise qu'une installation minimale avec les données dans le répertoire /opt/Ingres ce qui n'est pas le but visé.

Il suffit de lancer "./install.sh".

- Première question : "Please choose a location to install Ingres ", il faut indiquer le nom du répertoire d'installation du logiciel, ici "/opt/Ingres", ce répertoire sera ensuite "pointé" par la variable "II_SYSTEM".

- Deuxième question "Please choose a user to install Ingres ", indiquer "ingres" puisque nous avons créé cet utilisateur.

- On défile ensuite la licence GPL ... que l'on accepte ...

| Please identify the type of terminal (or terminal emulation software) you are using by entering its Ingres termcap name (e.g. 'vt100f' for a VT100 with a function key pad). If you do not know the termcap name for your terminal, press return to see a list of the available termcap names. Enter termcap name, or press return for a list: |

Répondre ici "konsole", un menu semi-graphique s'affiche alors :

| INGBUILD - Ingres Installation Utility ┌────────────────────────────────────────────────────────────────────────┐ │ II_SYSTEM: /opt/Ingres │ │ Distribution: /var/tmp/INSTALL/ingres-10.0.0-122-NPTL-gpl-linux-in │ └────────────────────────────────────────────────────────────────────────┘ Custom - Select this option in order to view the contents of the distribution medium and/or select components for installation on your system. This option will also allow you to upgrade an existing installation of INGRES products. Package - Select predefined packages for installation on your system. Help - See more instructions on using this program. To select a menu item, press ESC and type the name of the menu item. CustomInstall PackageInstall Help Quit : |

Choisir CustomInstall (Cu) l'écran suivant s'affiche :

| INGBUILD - Custom Install from Distribution Medium Distribution: /var/tmp/INSTALL/ingres-10.0.0-122-NPTL-gpl-linux-ingbuild-x ┌──────────────────────────────────────────────────────┬─────┬──────────┐ │ Custom Component Options │ Size│ Install? │ ├──────────────────────────────────────────────────────┼─────┼──────────┤ │Embedded SQL Precompilers │ 23M│Yes │ │Ingres 32bit support │ 42M│Yes │ │INGRES 6.x Compatible Message Files │ 4M│Yes │ │Ingres Intelligent DBMS │ 104M│Yes │ │Ingres DTP for Tuxedo │ 56M│Yes │ │Ingres Networking │ 66M│Yes │ │Ingres Object Management │ 879K│Yes │ │Ingres ODBC Driver │ 65M│Yes │ │Ingres Protocol Bridge │ 947K│Yes │ │Ingres C2 Security Auditing │ 25K│Yes │ │Ingres Replicator │ 2M│Yes │ └──────────────────────────────────────────────────────┴─────┴──────────┘ II_SYSTEM : /opt/Ingres To add or remove products from the list of products to be installed, enter 'y' or 'n' in the 'Install?' column. Install ExpressInstall GetInfo Help End |

Ici il faut vérifier que tout est à "Yes", puis choisir "Install" (F5), une "boite" affiche un petit récapitulatif :

| INGBUILD - Custom Install from Distribution Medium Distribution: /var/tmp/INSTALL/ingres-10.0.0-122-NPTL-gpl-linux-ingbuild-x +------------------------------------------------------+-----+----------+ | Custom+-----------------------------------------------------+ |=====================|Products selected: 16 Disk space required: 89M | |Ingres ODBC Driver | Support modules : 19 100M | |Ingres Protocol Bridg| -- Temporary storage : 10M | |Ingres C2 Security Au| ---- | |Ingres Replicator | Total: 35 199M | |Ingres Spatial Object| | |Ingres Data Access Se|Do you want to proceed with the installation? | |Ingres Star Distribut+-------------+---------------------------------------+ |Query and Reporting R|Yes |Install all selected products | |Query and Reporting T|No |Cancel requested installation | |Terminal Monitors +-------------+---------------------------------------+ |VisionPro | 66M|Yes | +------------------------------------------------------+-----+----------+ II_SYSTEM : /opt/Ingres To add or remove products from the list of products to be installed, enter 'y' or 'n' in the 'Install?' column. |

Il suffit de frapper "Entrée" sur le "Yes" présélectionné.

L'écran s'anime pendant la vérification puis propose dans une nouvelle "boîte" : "Do you want to set up these products now", frapper "Entrée" sur le "Yes" présélectionné.

Premier setup : "Setting up Application-By-Forms..."

Se contenter d'appuyer sur entrée, un petit message de confirmation s'affiche :

ING_ABFDIR configured as /opt/Ingres/ingres/abf

Application-By-Forms setup complete.

Press RETURN to continue:

Il faut encore faire "Entrée" puis un écran "Setting up the Ingres Intelligent DBMS..." récapitule les paramètres de Ingres DBMS, frapper "y" et "Entrée" puis le message suivant s'affiche :

| Ingres has the capability to guarantee integrity of all committed database transactions in the event of a system software failure or single storage device failure. IMPORTANT NOTE: if a second storage device fails before recovery from an initial failure has taken place, committed transactions may be lost. If you intend to take advantage of this capability, you need to have at least two independent storage devices available (one in addition to the one Ingres is being installed on). If you do not have two independent storage devices available, but would like to take advantage of this capability, you should not complete this setup procedure at this time. Do you want to continue this setup procedure? (y/n) [y] |

Il s'agit d'un écran d'information au sujet du système de logging, ce type d'écran appairatra par la suite pour les phases importants. Ingres permet d'utiliser un "dual log" sur un disque différent pour augmenter la sécurité des données en cas d'incident sur un disque. Nous ne nous servirons pas de cette fonctionnalité.

On frappe donc "y" et "Entrée" sans autre forme de procès et l'installeur génère la configuration par défaut. Celle-ci nous conviendra souvent.

Please enter a valid installation code [II]

Frapper "Entrée"

Do you want instructions on configuring your storage locations? (y/n) [y]

Les "locations" sont les répertoires où Ingres place les différentes catégories d'éléments (log, journal,bases de données, espace de travail ....) , la plupart de ces "locations" sont ensuite pointées par des variables de la forme "II_nom_variable",je préciserais ces éléments au passage, vous pouvez répondre "Y" et voir l'ensemble des conseils, ici je réponds "N".

II_DATABASE

Ici je désire que les données des bases soient placées dans le répertoire "/DATA/ingres", je réponds donc /DATA/ingres.

Please enter the default location for the Ingres Checkpoint Files:

[/opt/Ingres]

Les fichiers de "checkpoint" ne sont pas volumineux, ils peuvent très bien être stockés à l'endroit proposé, un jeu de sous-répertoires sera créé, il convient donc de faire "Entrée".

| ---------------------------------------------------------------------- | *** WARNING *** | | Do not store checkpoint, journal or dump files for a database on | | the same physical device as its data, or you will not be able to | | recover the data stored on that device if it fails. Please verify | | that the default location you have entered for your | | Ingres Checkpoint Files: | | /opt/Ingres | | is on a different physical device from the default location you | | have entered for your database files: | | /DATA/ingres | ---------------------------------------------------------------------- Is the value you have entered for II_CHECKPOINT correct? (y/n) |

Ce type de "warning" est affiché régulièrement afin de nous inciter à réfléchir à la sécurité de notre installation. Si nous sommes "bons" répondre "y" sans crainte.

Please enter the default location for the Ingres Journal Files:

[/opt/Ingres]

Ici aussi nous pouvons prendre cette valeur par défaut.

Please enter the default location for the Ingres Dump Files:

[/opt/Ingres]

Ici aussi nous pouvons prendre cette valeur par défaut.

Please enter the default location for the Ingres Work Files:

[/opt/Ingres]

Ici nous voulons utiliser le même disque que le log, nous mettons donc le nom de notre répertoire réservé : "/LOG/ingtemp".

Do you want to disable the backup transaction log? (y/n) [n]

Il s'agit ici du fameux "Dual_log" dont nous n'avons pas besoin pour une machine de test, il n'en serait pas de même en production où il faudrait le positionner sur un autre disque physique que le log standard, nous répondons donc "Y".

The default size for the Ingres transaction log is:

262144K bytes ( 256M bytes)

Do you want to change the default transaction log size? (y/n) [n]

Ici la taille proposée est de 256Mo, le log étant un buffer circulaire il est nécessaire de la positionner à une taille suffisante pour supporter la charge transactionnelle. Ici pour certains tests "lourds" il sera positionné à 4Go, répondons "n" pour pouvoir proposer une valeur différente.

Please enter the desired transaction log size (in Megabytes): 4096

Suivi de "Entrée"

Please enter a location for the Ingres transaction log:

[/opt/Ingres]

Mettre ici le répertoire que nous avons prévu pour ceci : "/LOG/ingres".

| You must now specify the number of CPUs (processors) in this machine so that Ingres may be set up for this server. If you do not know the exact number of CPUs, but know that this is a multi-cpu machine, enter a value of 2. The value you specify will be used to set the Ingres variable II_NUM_OF_PROCESSORS and possibly other configuration variables. Please enter the number of CPUs in this machine [1] Y |

Ici, un seul CPU est prévu, il faut ensuite choisir le fuseau horaire (en deux étapes), première liste :

AFRICA

ASIA

AUSTRALIA

MIDDLE-EAST

NORTH-AMERICA

NORTH-ATLANTIC

SOUTH-AMERICA

SOUTH-PACIFIC

SOUTHEAST-ASIA

GMT-OFFSET

Please enter one of the named regions:

Saisir "NORTH-ATLANTIC" qui envoie sur l'écran suivant où nous choisirons "EUROPE-WESTERN", il faut ensuite valider cette configuration.

The time zone you have selected is:

EUROPE-WESTERN (Western European Time Zone)

If this is not the correct time zone, you will be given the opportunity to

select another region.

Is this time zone correct? (y/n) [y]

La réponse est "y", sauf si l'on a fait n'importe quoi. Il faut ensuite choisir le jeu de caractères à utiliser pour les données :

This setting must be assigned one of the following values:

UTF8 ALT KOI8

PC857 ARABIC CW

DOSASMO ELOT437 GREEK

HEBREW HPROMAN8 IBMPC437

IBMPC850 IBMPC866 IS885915

ISO88591 ISO88592 ISO88595

ISO88597 ISO88599 CSGB2312

CSGBK CHINESET CHINESES

CHTHP CHTBIG5 CHTEUC

KANJIEUC KOREAN SHIFTJIS

PCHEBREW SLAV852 THAI

WARABIC WHEBREW WIN1250

WIN1252 WIN1253 WTHAI

Please enter a valid character set [ISO88591]

J'aime bien le "ISO885915" que je spécifie.

The character set you have selected is:

IS885915 (ISO-8859-15 (Latin 9))

Is this the character set you want to use? (y/n) [y]

Répondre "y" évidemment.

Cette "page" étant déjà très longue l'installation se poursuit sur une autre page.

Ingres : installer (2)

Ingres : installer (2) jppInstallation Ingres suite.

How many concurrent users do you want to support? [32]

Répondre "Entrée", 32 pour des tests c'est déjà pas mal. L'initialisation proprement dite de la BDD commence alors par le LOG

| The primary transaction log will now be created as an ordinary (buffered) system file. For information on how to create a "raw", or unbuffered, transaction log, please refer to the Ingres Installation Guide, after completing this setup procedure. Creating a 1048576K byte transaction log file... 0% 25% 50% 75% 100% |||||||||||||||||||||||||||||||||||| |

Cela dure quelques instants, le temps de formater 1Go sur le disque.

Do you wish to associate date data type to refer to ingresdate ? (y/n) [y]

Valider le "y".

Do you need strict compliance to the ANSI/ISO standard? (y/n) [n]

Valider le "n" cela déclenche l'installation proprement dite, les informations présentées ont été "raccourcies" :

| Ingres/ingstart Checking host "com-ingres" for system resources required to run Ingres... Your system has sufficient resources to run Ingres. Starting your Ingres installation... Starting the Name Server... Allocating shared memory for Logging and Locking Systems... Starting the Recovery Server... ..... Creating DBMS System Catalogs . . . Modifying DBMS System Catalogs . . . Creating Database Database System Catalogs . . . Modifying Database Database System Catalogs . . . Creating Standard Catalog Interface . . . Creating Front-end System Catalogs . . . ...... This setup process can create and populate a demonstration database (demodb) which will be used by the Ingres demonstration applications. Do you want demodb to be created? (y/n) [y] |

Répondre "y" et valider, nous disposerons ainsi d'une petite base de départ.

.....

la base "demo" s'installe

...

| ... executing checkpoint to disk ending checkpoint to disk /opt/Ingres/ingres/ckp/default/demodb of 1 locations Shutting down the Ingres server... Ingres Intelligent DBMS setup complete. Refer to the Ingres Installation Guide for information about starting and using Ingres. Press RETURN to continue: |

L'initialisation de la base est terminée on passe à la suite :

| Setting up Ingres Networking... ..... If you do not need access to this Ingres server from other hosts, then you do not need to set up Ingres Networking. Do you want to continue this setup procedure? (y/n) [y] |

Répondre "y" et valider

| Installation passwords offer the following advantages over user passwords: + Remote users do not need login accounts on the server host. + Installation passwords are independent of host login passwords. + Installation passwords are not transmitted over the network in any form, thus providing greater security than user passwords. + User identity is always preserved. If you need more information about Ingres Networking authorization, please refer to the Ingres Connectivity Guide. Press RETURN to continue: |

Comme d'habitude les conseils pour la suite, nous utiliserons un "Installation password".

Do you want to create an installation password for this server? (y/n)

Répondre "y" et valider.

.....

Enter installation password:

On entre un beau mot de passe ... et on confirme, on le note pour ne pas l'oublier ! .

| Installation password created. The name server has been shut down. Ingres Networking has been successfully set up in this installation. You can now use the "ingstart" command to start your Ingres server. Refer to the Ingres Installation Guide for more information about starting and using Ingres. Press RETURN to continue: |

En pressant "Return" on arrive sur la configuration "ODBC" :

Enter the default ODBC configuration path [ /usr/local/etc ]:

Valider sans remords

The default ODBC configuration path is /usr/local/etc

Is the path information correct? (y/n) [y]

Répondre "y" et confirmer la réponse.

The default ODBC configuration path is /usr/local/etc

Is the path information correct? (y/n) [y] y

Répondre "y" sans hésiter

Is this always a read-only driver? (y/n) [n]

Sur une machine de production répondre "y" sans hésiter, ici on laisse "n" et on confirme ce manquement à la sécurité, la réponse ne se fait pas attendre :

Could not open from path /usr/local/etc.

E_CL1904_SI_CANT_OPEN SIfopen: Can't open file

Cannot write to specified ODBC configuration path /usr/local/etc

Writing instead to /opt/Ingres/ingres/files/odbcinst.ini.

Successfully wrote ODBC configuration files

An odbcinst.ini file has been created in the directory "/opt/Ingres/ingres/files".

You may use the utility iiodbcadmn to create and manage

ODBC data sources.

See the Ingres Installation Guide for more information.

Press RETURN to continue:

C'était bien la peine ! On copiera ce fichier plus tard.

Le setup de "Ingres Protocol Bridge..." se passe sans question --> Return.

Le setup de "C2 Security Auditing" se passe sans encombres, il faut valider puis "Setting up Replicator" s'affiche, il faut là aussi valider et on enchaine sur :

| Setting up the Ingres Data Access Server... This procedure will set up the following version of Ingres Data Access Server: II 10.0.0 (a64.lnx/122)NPTL to run on local host: com-ingres Do you want to continue this setup procedure? (y/n) [y] |

Répondre "y" et valider et on arrive sur la configuration data access server et de JDBC qui se passe sans autre question.

| Executing Ingres JDBC driver properties generator utility... The JDBC driver properties file 'iijdbc.properties' was created in $II_SYSTEM/ingres/files directory Ingres Data Access Server has been successfully set up in this installation. Please adjust the startup count and check the listen address with the cbf utility. Press RETURN to continue: |

On presse, encore, "Entrée" pour passer à la configuration (automatique) de "Ingres Star" à suivre de l'appui sur "Entrée".

| INGBUILD - Custom Install from Distribution Medium Distribution: /var/tmp/INSTALL/ingres-10.0.0-122-NPTL-gpl-linux-ingbuild-x +------------------------------------------------------+-----+----------+ | Custom Component Options | Size| Install? | |======================================================+=====+==========| |Embedded SQL Precompilers | 23M|Ready | |Ingres 32bit support | 42M|Ready | |INGRES 6.x Compatible Message Files | 4M|Ready | |Ingres Intelligent DBMS | 104M|Ready | |Ingres DTP for Tuxedo | 56M|Ready | |Ingres Networking | 66M|Ready | |Ingres Object Management | 879K|Ready | |Ingres ODBC Driver | 65M|Ready | |Ingres Protocol Bridge | 947K|Ready | |Ingres C2 Security Auditing | 25K|Ready | |Ingres Replicator | 2M|Ready | +------------------------------------------------------+-----+----------+ II_SYSTEM : /opt/Ingres +----------------------------------------------------------------------------+ | All installed products are now available for use. | | [PRESS RETURN] | +----------------------------------------------------------------------------+ |

Le dernier appui sur "Entrée" avant l'appui sur "F3" pour sortir de l'installeur.

Ensuite le démarrage normal du serveur Ingres est déclenché et se termine par :

Starting the Visual DBA Remote Command Server...

Ingres installation successfully started.

Building the password validation program 'ingvalidpw'.

Executable successfully installed.

L'installation est terminée le répertoire /opt/Ingres/ingres contient :

drwxrwxrwx 2 ingres ingres 4096 mai 3 16:57 abf

drwxr-xr-x 2 ingres ingres 4096 mai 3 17:12 bin

drwx------ 3 ingres ingres 4096 mai 3 16:58 ckp

drwxr-xr-x 5 ingres ingres 4096 avr 21 19:49 demo

drwx------ 3 ingres ingres 4096 mai 3 16:59 dmp

drwxr-xr-x 16 ingres ingres 4096 mai 3 17:12 files

drwxrwxrwx 3 ingres ingres 4096 avr 21 19:49 install

drwx------ 3 ingres ingres 4096 mai 3 16:59 jnl

drwxr-xr-x 3 ingres ingres 4096 mai 3 16:57 lib

drwxrwxrwx 3 ingres ingres 4096 mai 3 17:10 rep

drwxr-xr-x 10 ingres ingres 4096 avr 21 19:49 sig

drwxrwxr-x 3 ingres ingres 4096 avr 21 19:48 utility

drwxr-xr-x 2 ingres ingres 4096 mai 3 17:04 vdba

-rw-r--r-- 1 ingres ingres 28 avr 21 19:28 version.rel

Après cette installation épuisante un peu de repos avant de passer aux ajustements nécessaires à une utilisation "normale" de Ingres.

Ingres : ajustements

Ingres : ajustements jppAvant les quelques ajustements nécessaires à une utilisation agréable une petite explication sur les "locations".

Les "locations" sont pour Ingres des espaces disques où peuvent être installées des bases de données ou des parties de bases de données, pour Oracle on utilise le mot "tablespace". Dans ces locations, pour chaque base, Ingres crée un répertoire portant le nom de la base. Un fichier (au sens OS) est ensuite créé pour la plupart des objets de base de données (tables, index ...).

Toute base a, au moins, une location ou créer les bases "iidbdb" et "imadb".

- iidbdb = "base des bases", c'est le catalogue général de Ingres.

- imadb = base contenant essentiellement des éléments liés à la performance.

Variables "système" à mettre en place impérativement :

II_SYSTEM mettre à '/opt/Ingres'

II_INSTALLATION mettre à II

PATH y ajouter $II_SYSTEM'/ingres/bin' et $II_SYSTEM'/ingres/lib'

LD_LIBRARY_PATH y ajouter $II_SYSTEM'/ingres/lib'

INGRES_TERM à mettre à "vt220"

TERM à mettre à "vt220", on dispose alors d'un aspect et de fonctionnalités correctes dans une "konsole" pour les utilitaires "semi-graphiques" qui font le délice des amateurs.

Un petit script à placer par exemple dans le fichier /etc/default/ingres et lancé par "source /etc/default/ingres" dans son ".bashrc" favori, un tel script est fourni en fichier attaché.

Ne pas oublier d'utiliser le "bon" type de terminal (pour moi "konsole") et forcer "TERM" et "INGRES_TERM" à "vt220". Mettre cela dans votre profil.

Les utilitaires :

- ingstart sert a démarrer la base

- ingstop sert à stopper la base, possède quelque switchs d'usage courant "-force, -immediate, -kill" et d'autres à découvrir en tapant "ingstop -h".

- ingstatus permet de voir les process "Ingres" et leur état

- cbf très important, sert à gérer les paramètres de la base.

- accessdb qui permet de gérer bases, locations et utilisateurs

Ceci dit penchons nous sur quelques scripts qui facilitent la vie :

- Script de connexion

Le script proposé "ingres" est en à installer dans /etc/default et est "sourcé" dans les scripts de connexion des utilisateurs (ou exécuté par . /etc/default/ingres )

Ce script est par ailleurs utilisé dans les scripts de démarrage proposés.

Afficher ce script. - Script de démarrage (automatique)

Le script proposé est en deux parties :

Un script coté "ingres" : start_stop à installer dans $II_SYSTEM/ingres

Afficher ce script.

Un script coté "système" : ingres_cmd à installer dans /etc/init.d avec les bons liens qui se contente d'appeler le script "ingres"

Afficher ce script. - NB : les fichiers attachés doivent être renommés en supprimant de suffixe ".txt"

Compléments de configuration :

La partie essentielle est la configuration des caches. Ingres permet de créer des bases avec différentes tailles de page (une taille est à choisir pour la valeur par défaut), on peut même avoir des tables avec des tailles différentes dans la même base.

Ici nous prendrons des pages de 8K pour se comparer aux autres bases déjà testées "à armes égales".

Petit tour dans "cbf" qui a la "gueule" habituelle.

| CBF - Configuration-By-Forms Host: com-ingres II_SYSTEM: /opt/Ingres II_INSTALLATION: II ┌────────────────────────┬────────────────────────┬───────────────┐ │System Component │Configuration Name │Startup Count │ ├────────────────────────┼────────────────────────┼───────────────┤ │Name Server │(default) │1 │ │DBMS Server │(default) │1 │ │Star Server │(default) │0 │ │Locking System │(default) │1 │ │Logging System │(default) │1 │ │Transaction Log │II_LOG_FILE │1 │ │Transaction Log │II_DUAL_LOG │0 │ │Recovery Server │(default) │1 │ │Archiver Process │(not configurable) │1 │ │Remote Command │(not configurable) │1 │ │Security │(default) │1 │ └────────────────────────┴────────────────────────┴───────────────┘ Configure(1) EditCount(2) Duplicate(3) ChangeLog(8) > |

On commence par mettre à zero de "Startup count" de "Star Server" en :

- se positionnant sur la bonne ligne

- appuyant sur "F1" pour aller dans la zone de commandes

- Frappant "Ed" pour EditCount

On obtient alors une zone de saisie pour la variable concernée : ┌────────────────────────────────────────────────────────────────────────────┐

│ Please enter the number of copies of the selected component you want to │

│ execute at startup: │

│ └────────────────────────────────────────────────────────────────────────────┘

On peut alors entrer la valeur souhaitée (ici 0) suivie de "Entrée".

Toutes les actions s'exécutent, après affichage de la liste, selon le même principe :

- se positionnr sur l'élément à modifier

- appuyer sur "F1"

- frapper le début de la fonction à exécuter

- réaliser son rêve, frapper "Entrée".

Pour configurer le "DBMS Server" :

- se positionner sur la ligne "DBMS Server"

- Frapper sur "F1"

- Frapper "co" pour "configure"

- accéder à la liste des valeurs de configuration

La liste peut être parcourue, un appui sur "F2" donne accès à une aide dont on sort par "F3".

Dans cette liste on remarque la variable "connect_limit" positionnée à 32 si vous avez bien suivi la configuration

de départ. Ce qui nous intéresse dans un premirr temps est le "default_pagesize" magnifiquement déjà positionné

à 8K.

On va vérifier la taille des caches, "F1" puis saisir "cache" on voit alors que les caches de 2k et 8K sont "on", on

se positionne sur le cache "8K", un petit coup de "F1" puis configure nous amène :

| ┌──────────────────────────────────────────────────────────────┐ │ DBMS Cache Parameters for 8k Buffers │ ├────────────────────┬────────────────────┬────────────────────┤ │Name │Value │Units │ ├────────────────────┼────────────────────┼────────────────────┤ │cache_guideline │medium │ │ │dmf_group_size │8 │data pages │ │dmf_separate │OFF │boolean │ │dmf_write_behind │ON │boolean │ │ │ │ │ └────────────────────┴────────────────────┴────────────────────┘ Edit(2) Derived(5) Restore(6) ChangeLog(8) Help(PF2) > |

Un petit coup de "Derived" sur "cache_guideline" nous affiche le détail de la mémoire affectée :

| ┌────────────────────────────────────────────────────────────────────────┐ │ Derived DBMS Cache Parameters for 8k │ ├────────────────────┬────────────────────┬────────────────────┬─────────┤ │Name │Value │Units │Protected│ ├────────────────────┼────────────────────┼────────────────────┼─────────┤ │dmf_cache_size │24000 │data pages │no │ │dmf_free_limit │750 │data pages │no │ │dmf_group_count │750 │group buffers │no │ │dmf_memory │245760000 │bytes │no │ │dmf_modify_limit │18000 │data pages │no │ │dmf_wb_end │7200 │data pages │no │ └────────────────────┴────────────────────┴────────────────────┴─────────┘ |

J'ai "forcé" le "dmf_cache_size à 24000 et je force dmf_free_limit et dmf_group_count à 2400 pour affecter un peu plus de mémoire aux buffers. Je ne touche pas aux autres valeurs.

Les autres valeurs fixées par défaut ne doivent pas être modifiées sans un besoin précis (machines de production) et des avis "autorisés" sous peine de manque de performance, l'utilisation de la touche "F2" permet de se documenter sur les variables.

Après notre petit "bricolage" on sort de ces modifications par "F3" et cbf nous propose de sauvegarder nos mises à jour, nous restons positionnés sur "Yes" et l'appui sur "Entrée" sauvegarde le tout. Un appui sur "F4" nous permet de sortir définitevement de cbf. Il ne nous reste plus qu'à appliquer nos modifications :

"ingstop -immediate" cela rappelle le "shutdown immediate;" de Oracle ?

Puis :

"ingstart"

Et c'est Parti ...

Ingres : minitest

Ingres : minitest jppLa table "habituelle" a été reconstituée à grans coups de "insert/select". Toutefois la syntaxe permettant de "décaler" vers le passé les dates "historiques" conservées en format "texte" AAAAMMJJ n'est pas évidente et forte consommatrice de CPU.

Calcul des statistiques (optimizedb) (doc disponible) :

optimizedb -utest -zu4096 -zv test -rxen_stat_v2

ven mai 7 11:41:25 CEST 2010

*** statistics for database test version: 01000

*** table imp_xen rows:793466 pages:15561 overflow pages:15558

*** column nbsecw of type decimal (length:10, scale:2, nullable)

date:07-may-2010 10:41:28 unique values:801.000

repetition factor:990.5942383 unique flag:N complete flag:0

domain:0 histogram cells:1602 null count:0.0000000 value length:8

*** statistics for database test version: 01000

*** table imp_xen rows:793466 pages:15561 overflow pages:15558

*** column nbsecr of type decimal (length:10, scale:2, nullable)

........

*** statistics for database test version: 01000

*** table xen_stat_v2 rows:13195433 pages:206183 overflow pages:206177

*** column deltacpu of type decimal (length:10, scale:2, nullable)

date:07-may-2010 10:43:00 unique values:61.000

repetition factor:216318.5781250 unique flag:N complete flag:0

domain:0 histogram cells:122 null count:0.0000000 value length:8

ven mai 7 11:43:00 CEST 2010

Soit un temps de 1 minute et 25 secondes.

Création du premier index :

sql -utest test <statv2_cre_idx.sql

INGRES TERMINAL MONITOR Copyright 2010 Ingres Corporation

Ingres Linux Version II 10.0.0 (a64.lnx/122)NPTL login

Wed May 5 14:42:31 2010

continue

* * * * * * * * * /* SQL Startup File */

create index xen_stat_v2_i1 on xen_stat_v2 (DOMNOM, DATEC, HEUREC) ;

Executing . . .

(13147446 rows)

continue

Your SQL statement(s) have been committed.

Ingres Version II 10.0.0 (a64.lnx/122)NPTL logout

Wed May 5 14:44:30 2010

Soit environ 1 minute 59 secondes.

Création du second index :

sql -utest test <statv2_cre_idx.sql

INGRES TERMINAL MONITOR Copyright 2010 Ingres Corporation

Ingres Linux Version II 10.0.0 (a64.lnx/122)NPTL login

Wed May 5 14:47:34 2010

continue

* * * * * * * * * /* SQL Startup File */

create index xen_stat_v2_i2 on xen_stat_v2 (DATEC, DOMNOM, HEUREC) ;

Executing . . .

(13147446 rows)

continue

*

Your SQL statement(s) have been committed.

Ingres Version II 10.0.0 (a64.lnx/122)NPTL logout

Wed May 5 14:49:50 2010

Soit environ 2 minutes et 16 secondes.

Comptages :

1) comptage "brut"

sql -utest test <CNT_1.sql

INGRES TERMINAL MONITOR Copyright 2010 Ingres Corporation

Ingres Linux Version II 10.0.0 (a64.lnx/122)NPTL login

Wed May 5 14:53:09 2010

* * * * * * /* SQL Startup File */

select count(*) from xen_stat_v2

Executing . . .

┌─────────────┐

│col1 │

├─────────────┤

│ 13147446│

└─────────────┘

(1 row)

continue

*

Your SQL statement(s) have been committed.

Ingres Version II 10.0.0 (a64.lnx/122)NPTL logout

Wed May 5 14:53:25 2010

Soit environ 16 secondes.

2) Comptage group by

sql -utest test <CNT_GRP_1.sql

INGRES TERMINAL MONITOR Copyright 2010 Ingres Corporation

Ingres Linux Version II 10.0.0 (a64.lnx/122)NPTL login

Wed May 5 14:55:09 2010

* * * * * * * * /* SQL Startup File */

select domnom,count(*)

from xen_stat_v2

group by domnom

order by domnom

Executing . . .

┌────────────────┬─────────────┐

│domnom │col2 │

├────────────────┼─────────────┤

│Domain-0 │ 2512057│

│amdx2-2000 │ 254925│

│amdx2-bi2003 │ 255541│

......

│k2000-ora64 │ 2333479│

│k2000-ora65 │ 898205│

│k2000-ora66 │ 862580│

└────────────────┴─────────────┘

(19 rows)

continue

*

Your SQL statement(s) have been committed.

Ingres Version II 10.0.0 (a64.lnx/122)NPTL logout

Wed May 5 14:55:29 2010

Soit environ 20 secondes.

3) Comptage "group by"

sql -utest test <CNT_GRP_2.sql

INGRES TERMINAL MONITOR Copyright 2010 Ingres Corporation

Ingres Linux Version II 10.0.0 (a64.lnx/122)NPTL login

Wed May 5 14:57:04 2010

continue

* * * * * * * * /* SQL Startup File */

select domnom,serveur,count(*)

from xen_stat_v2

group by domnom,serveur

order by domnom,serveur

Executing . . .

┌────────────────┬────────────────┬─────────────┐

│domnom │serveur │col3 │

├────────────────┼────────────────┼─────────────┤

│Domain-0 │k2000 │ 2305773│

......

│k2000-ora66 │k2000 │ 862580│

└────────────────┴────────────────┴─────────────┘

(24 rows)

continue

*

Your SQL statement(s) have been committed.

Ingres Version II 10.0.0 (a64.lnx/122)NPTL logout

Wed May 5 14:57:38 2010

Soit environ 34 secondes.

En bref la base de données est assez rapide et n'a pas à rougir devant les performances des autres bases existantes. La gestion des bases Ingres est très simple, beaucoup de bases utilisées dans l'industrie tournent sans aucun DBA qualifié. Si la base est bien installée (répartition et place disque) et paramétrée correctement (taille mémoire, log, espace temporaire, système de "lock") elle peut fonctionner des années quasiment sans intervention, cela n'empêche pas de sauvegarder les données !

Petit rappel sur l'outil "sql".

L'outil "sql" utilisé pour les tests est l'outil "batch" de Ingres (il peut aussi être utilisé "à la main" bien sûr).

La syntaxe SQL est assez standard, seuls quelques "trucs" peuvent gêner :

- exécuter l'ordre SQL courant : il faut frapper "\g" pour lancer l'exécution ou "\p\g" pour lister l'ordre et l'exécuter.

- quitter : il faut frapper "\q"

Le prompt est marqué par un "*" exemple :

* help\g

Executing . . .

Name Owner Type

xen_stat_v2 test table

xen_stat_v2_i1 test index

xen_stat_v2_i2 test index

(3 rows)

continue

*\q

Il faut le savoir ... pour la doc c'est ici.

Rappel sur les "switchs" :

Attention dans Ingres, les switchs de commande comme le "-u" dans "sql -utest" ne doivent pas être suivis d'un espace contrairement à beaucoup d'autres logiciels.

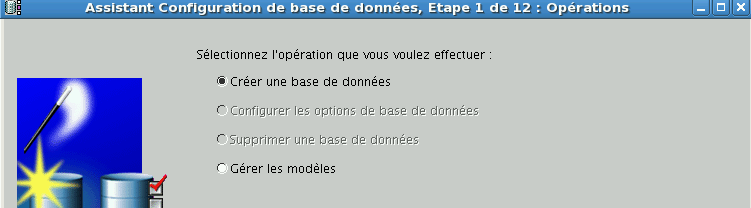

Sybase

Sybase jppUn chapitre sur Sybase comprenant plusieurs articles dont le premier concerne l'inévitable installation. La version présentée ici est la version 15 de Sybase dans la déclinaison "développeur" qui est complètement fonctionnelle et ne souffre que de faibles limitations ( essentiellement limitée à un process serveur).

L'installation a été réalisée sur un support "Centos" en version 5.4 (X86_64 en machine virtuelle XEN) qui convient très bien à la version la plus récente de Sybase.

Une installation de la partie système est détaillée dans un autre article.

La machine virtuelle d'installation dispose de :

- 1 CPU

- 1536 Mo de RAM

- 3 disques de 16 Go

- un pour le système

- un pour les données

- un pour les log et les espaces temporaires

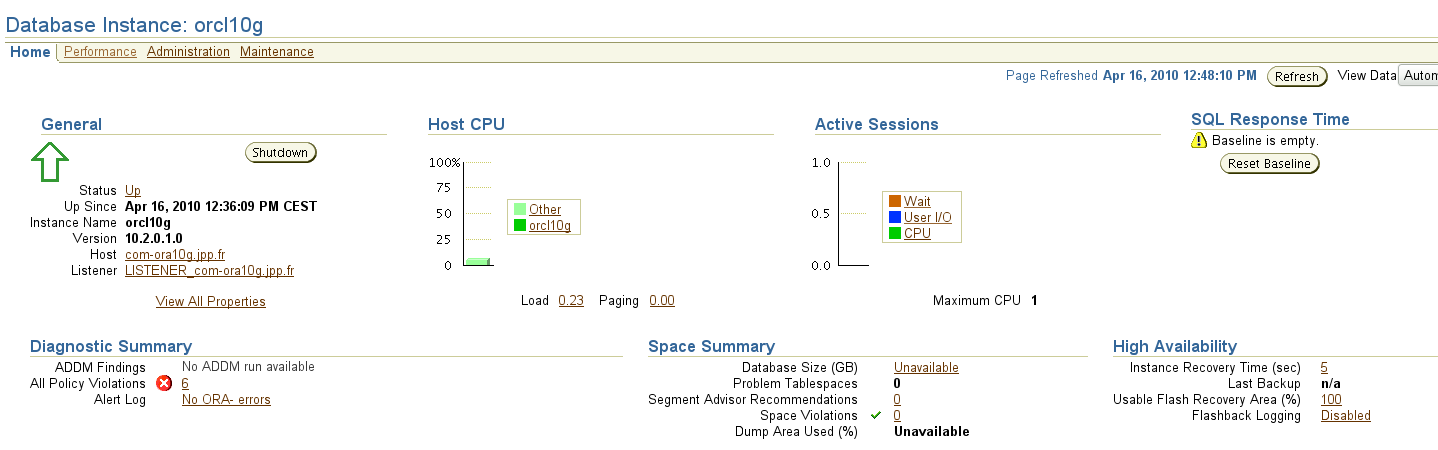

Je dispose par ailleurs d'une machine virtuelle Oracle 10g (sur Oracle Linux 4.8) présentant des caractéristiques analogues, cela permettra d'établir quelques comparaisons.

Sybase : Installation

Sybase : Installation jppRappel : La machine choisie pour cette installation est une machine fraîchement installée avec une Centos 5.4 sous XEN zt munie de :

- RAM : 1,5G

- CPU : 1

- Disques :

- 16G système

- 16G données

- 16G temporaire et logs

Bien que l'on puisse avec profit en performance utiliser des "raw-devices" : partitions non gérées par l'OS, j'ai choisi d'utiliser des fichiers traditionnels du file-système.

Pré-requis :

- créer un utilisateur "sybase"

- Créer un répertoire "/opt/sybase" avec propriétaire "sybase"

- Créer un répertoire "SYBDAT" avec propriétaire "sybase" dans le deuxième disque monté sur /DATA

- créer un répertoire "SYBTMP" avec propriétaire "sybase" dans le troisième disque monté sur /LOG

Détarer l'archive dans un répertoire "propre", au premier niveau deux fichiers :

- un fichier décrivant les limites légales du logiciel

- setup.bin

et un répertoire d'archives contenant le logiciel à installer.

Installation.

Se connecter en X et ouvrir une fenêtre terminal, dans le répertoire d'installation, un simple "./setup.bin" lance l'installeur (Java comme beaucoup) qui ouvre sa fenêtre en attendant l'appui sur la touch "Next". Tiens pas de français ?

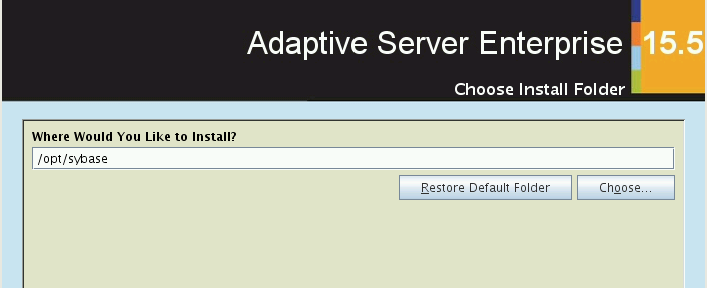

Après l'appui sur "Next" écran "Choose Install Folder"

L'écran propose "/opt/sybase" il est sage de l'accepter et de cliquer sur "Next".

L'écran suivant propose 3 options : "Typical", "Full" et "Custom", étant audacieux je choisis "Full", autant disposer du maximum de possibilités.

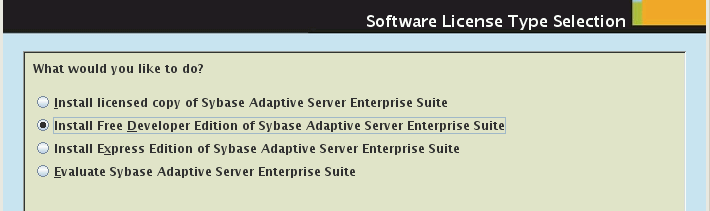

L'écran suivant "Software license type selection" :

N'ayant pas de license, nous choisirons la version "Free developper".

Puis il faut définir son pays pour lire le contrat de license dans sa langue ... non, une seule possibilité "All regions" et c'est en anglais ... J'aime bien les questions à choix simple ! Je clique "I agree" (ça veut dire quoi ?) et "Next".

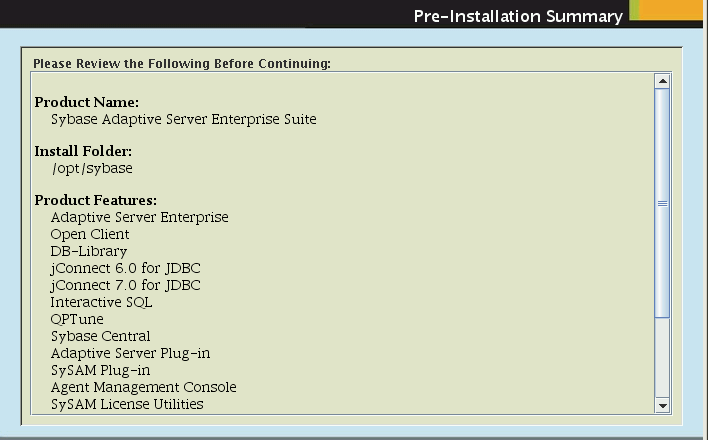

Un pétit écran de récap :

il me semble que tout est là, même "Sybase Central" que l'on avait parfois du mal à trouver et les drivers JDBC et ODBC. L'installation complète consomme un peu plus de 1,1Go.

Il ne reste plus qu'à cliquer sur "Install", ce que je m'empresse de faire, l'installation du logiciel démarre avec le petit baratin publicitaire défilant qui nous occupe pendant l'installation. C'est vachement à la mode.

La fin de l'installation arrive et on nous propose de "retenir" ou non les mots de passe. N'ayant pas besoin de sécurité pour des tests je choisis "Enable" par paresse et clique sur "Next".

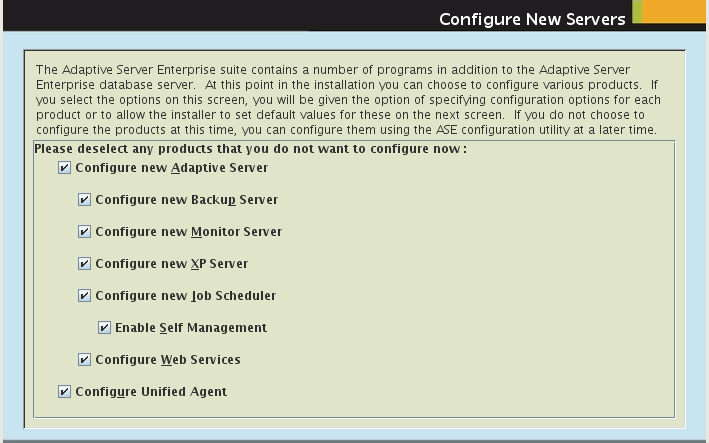

On arrive maintenant aux points importants : la configuration des différents serveurs constituant Sybase :

Il vaut mieux les configurer tous dès le début, cela sera toujours cela de fait, on entre ensuite dans un écran spécifique à chaque process serveur.

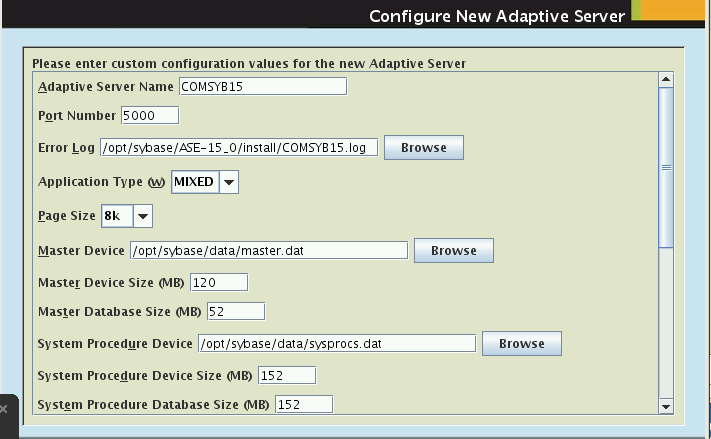

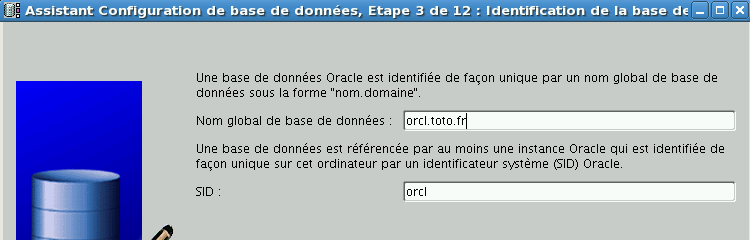

Ecran "Configure New Adaptative Server"

nous propose de nombreux paramètres :

- Nom , celui préparé me va ...

- Port number : 5000 ne me gêne pas

- Application type : je garde "Mixed" car je désire faire plein de choses

- Page size : Les anciennes pages de 2K étaient un peu trop petites, je vais prendre 8K comme la plupart des bases Oracle.

- Fichiers de log, je les mets tous dans /opt/sybase/log

- Devices : c'est comme cela que Sybase nomme les fichiers de données, un certain nombre de "devices" sont obligatoires, il s'agit de leur donner un emplacement physique et une taille. Les tailles proposées par Sybase sont en général un peu "justes" pour des machines d'exploitation, mais ici cela devrait nous suffire. Ces espaces obligatoires sont analogues aux tablespaces "System", "TEMP" ... pour Oracle.

- Master device : /DATA/SYBDAT/master.dat

- Master device size : 128

- Master database size : 64

- System procedure device : /DATA/SYBDAT/sysprocs.dat

- System procedure device size : 160

- System procedure database sise : 160

- System Device : /DATA/SYBDAT/sybsysdb.dat

- Sstem device size : 32

- System database size : 32

- Tempdb device : je le positionne sur un autre disque /LOG/SYBTMP/tempdbdev.dat

- Tempdb device size : 256

- Tempdb database size : 256

- Enable PCI : je le laisse à "no"

- Optimize ASE configuration : "yes"

- available physical memory pour ASE : 1024

- available CPU for ASE : 1 (limité à 1 pour la version developpeur).

Un petit "Next" et juste un Warning car j'ai choisi des pages de 8K ce qui est incompatible avec le rechargement de bases "anciennes" qui avaient, en principe, des pages de 2K et nous voilà sur le paramétrage du "Backup Server" :

- Name : je le laisse

- Port number : pourquoi pas 5001

- error log : je le laisse

"Next" nous emporte vers le "Monitor Server"

- Nom : je le laisse

- Port Number : 5002 n'est pas pire qu'un autre

- Error log : je le laisse

"Next" conduit vers le paramétrage du "Xp Server" avec son port 5003 et son error log, un autre "Next" nous donne accès au paramétrage du "Job scheduler". Tiens un port number à 4900 ? Pour le reste les valeurs par défaut sont convenables. Après le "Next" suivant nous arrivons au "saint des saints" le superuser "sa" sans possibilité de toucher au mot de passe puisque on a choisi "Enable" pour la gestion des mots de passe .

Et maintenant les "Web Services" avec un paquet de ports et de mots de passe ...on laisse les valeurs par défaut (sauf pour les mots de passe !).

Encore un "Next" pour le "Self Discovery Service Adaptor" que je choisis de configurer le "UDP Adaptor" et je refuse le "JNI" comme j'en ai le droit !

Encore "Next" pour arriver sur "Security modules" où je ne coche que les deux premiers. Le "Next" nous permet, enfin, d'arriver à la fin de la configuration et le récap nous permet de revoir un peu tous nos choix avant de cliquer un autre "Next" qui déclenche la création de la base de données et l'affichage des logs des scripts de création et c'est la fin de ce roman passionnant

Cette partie est assez longue car Sybase crée les fichiers de data et les remplit intégralement : ce qui est pris n'est plus à prendre, la place prise est bien réservée.

Avant de pouvoir s'en servir allons voir un peu le répertoire d'installation qui comporte plein de répertoires ... avec de nombreux sous répertoires "bin" qu'il va falloir ajouter à notre "PATH" avant de pouvoir faire mumuse.

Heureusement on peut trouver dans "/opt/sybase" le merveilleux script "SYBASE.sh" qui fait çà très bien ". /opt/sybase/SYBASE.sh" résout ce problème pour nous.

Dans un prochain épisode le lancement des premières commandes, vous apprendrez à mettre des "go" partout dans "isql".

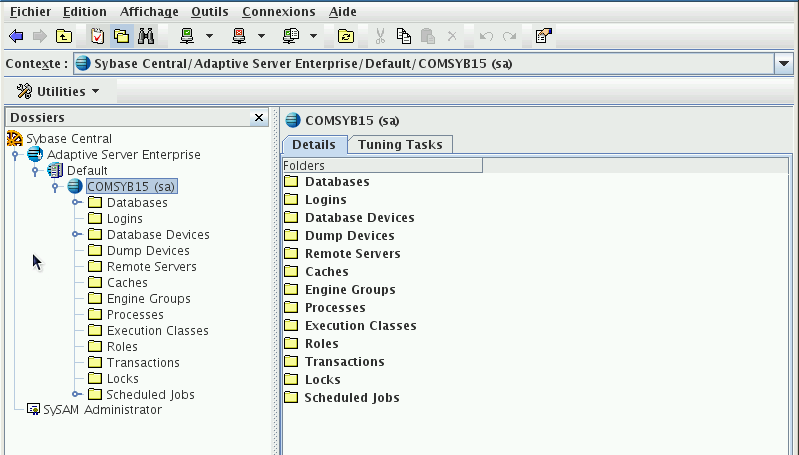

Pour vous mettre l'eau à la bouche une petite image de l'outil de gestion "Sybase Central"

que l'on peut lancer par :

./shared/sybcentral600/scjview.sh

puis se connecter (clic droit sur "Adaptative Server Enterprise" + "Connect", pas de mot de passe (il est stocké, rappelez vous le "Enable". Ici beaucoup de choses se commandent par le "clic droit" et les menus associés.

Vous avez alors accès au module central de gestion de Sybase qui vous permet même de gérer plusieurs serveurs simultanément, ce module est une véritable "tour de contrôle".

Sybase : ajustements

Sybase : ajustements jppAprès l'installation il reste toujours quelques "bricoles" à faire pour avoir un système plus commode et agréable à utiliser.Modifier le .profile (ou le .bashrc) du user de test pour y insérer l'appel à "/opt/sybase/SYBASE.sh" afin de pouvoir travailler sans penser sans arrêt à frapper :

. /opt/sybase/SYBASE.sh

Un certain nombre d'ajustements sont indispensables, par exemple "isql" n'aime pas ma locale "fr_FR@euro" (variable LANG), il faudra "forcer" la valeur de LANG à une valeur compatible avec celles existant dans le fichier "/opt/sybase/locales/locales.dat".

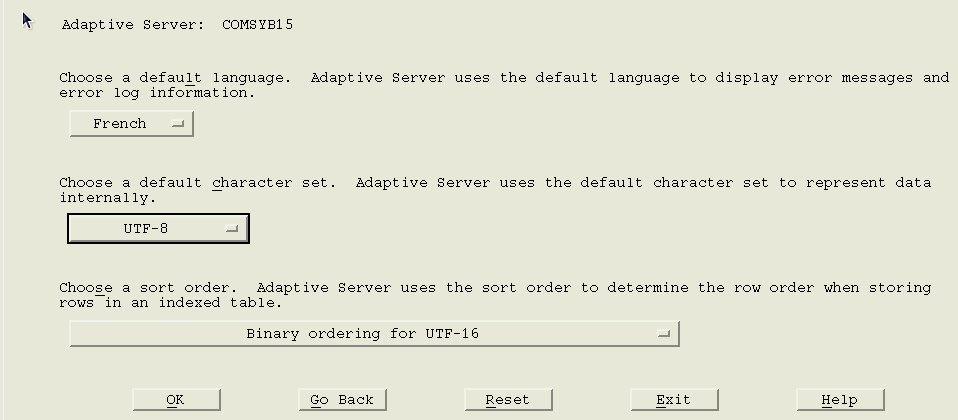

Mettre en place la langue "français".

Il faut passer par l'utilitaire "sqlloc" (/opt/sybase/ASE-15_0/bin/sqlloc) qui permet de réaliser cet exploit dans un mode semi-graphique

Ne pas oublier de modifier le "default character set".

Ma machine utilise les "locales" fr_FR.UTF-8 il m'a fallu pour terminer ajouter une ligne descriptive dans le fichier "/opt/sybase/locales/locales.dat" :

locale = fr_FR.UTF-8, french, iso_1

est à insérer dans le paragraphe [linux] après "fr_FR.850 ...". Il reste quelques "bricoles" au niveau des caractères accentués dans les messages, mais les caractères stockés dans la base ressortent correctement..

Ces petites mises au point permettent d'ajouter au script "SYBASE.sh" les lignes suivantes :

LANG=fr_FR.UTF-8

SYB=/opt/sybase

export SYB

On peut ensuite oeuvrer tranquilles sans messages, ou refus, intempestifs lors du lancement des utilitaires.

Avant de faire quoi que ce soit d'autre il faut :

- créer un "login" pour pouvoir réaliser des tests

- créer deux "devices" pour pouvoir créer une base de données de test car il est très fortement déconseillé de créer des objets dans les espaces "système".

Device numéro 1 pour les "data'

Device numéro 2 pour le "log"

- créer une base de données pour les tests

Les scripts fournis peuvent être lancés par :

cd le_repertoire_de_stockage_des_scripts

isql -Usa -SCOMSYB15 -D master -i le_nom_du_script

A la demande de password frapper "Entrée" tout simplement.

Les scripts fournis ici doivent être personnalisés.

- Script de création du device "DATA" :

disk init name='MABASE', physname='/DATA/SYBDAT/MABASE.dat', vdevno=5,

size=524288, cntrltype=0, dsync=false, directio=true, skip_alloc= true

go

- Script de création du device "LOG" :

disk init name='MONLOG', physname='/LOG/SYBTMP/MONLOG.dat', vdevno=6, size=262144,

cntrltype=0, dsync=false, directio=true, skip_alloc= true

go

- Script de création de la base de données "MABASE" :

create database MABASE on MABASE = 1024 log on MONLOG = 512 with DURABILITY=FULL - Script de création du user "test" :

use master

go

exec sp_addlogin 'test', 'testpw', @defdb = 'MABASE', @deflanguage = 'french',

@auth_mech = 'ANY', @fullname='User pour tests'

go

- Donner la propriété de la base au user "test"

USE MABASE

go

exec sp_changedbowner 'test', true

go

Quelques "trucs" :

- Démarrer le serveur Sybase :

cd /opt/sybase

nohup ./ASE-15_0/install/RUN_COMSYB15

On peut lancer de la même façon le "Backup server" (RUN_COMSYB15_BS) ou le "Monitor Server" (RUN_COMSYB15_MS).

- Stopper le serveur Sybase

isql -U user_stop -S COMSYB15 -P mot_de_passe <<!FINI

shutdown SYB_BACKUP

go

shutdown

go

exit

!FINI

Les scripts nécessaires sont fournis en pièces attachées (root : "sybase" à installer dans /etc/init.d, sybase "start_stop_sybase" à installer dans /home/sybase/bini en enlevant le suffixe ".txt" des fichiers, sans oublier le "chown +x ..." qui va bien).

- Se connecter avec "isql" :

isql -Usa -P -Snom_serveur -D nom_de_la_base

Installation des outils nécessaires pour accéder à la base par JDBC.

Il est nécessaire d'installer un ensemble de tables dans la base "master" afin que la connexion JDBC soit possible sur la base, il existe deux versions de "JConnect" dans les répertoires de Sybase 15 : JConnect 6 et JConnect 7. Ici j'ai décidé d'installer la version 7.

Ill faut aller dans le répertoire "/opt/sybase/jConnect-7_0/sp" et de lancer le script qui va avec la version de la base, ici le script "sql_server15.0.sql" à lancer par :

isql -U sa -S COMSYB15 -i sql_server15.0.sql -o MONLOG.LOG

(répondre "Entrée" à la demande de mot de passe). Il est ensuite possible de se connecter en JDBC aux différentes bases de données contenues dans cette instance.

Sybase : mini test

Sybase : mini test jppLe mini test a été réalisé selon la procédure décrite ici.

Calcul de la différence de dates :

set statistics time on

go

select min(convert(datetime,DATEC)) as MINI,

max(convert(datetime,DATEC)) as MAXI,

datediff(day,min(convert(datetime,DATEC)),max(convert(datetime,DATEC))) as DIFF,

count(*) as CTR

from xen_stat_v2

go

Génération de la table table temporaire :

set statistics time on

go

select convert( char(10),dateadd(day, DELTA ,convert(datetime,DATEC)),112) as DATEC, HEUREC,SERVEUR,DOMNOM,DELTACPU,DELTARX,DELTATX,CPUPCT,NBSECR,NBSECW

into toto

from xen_stat_v2

go

Insertion des rangs calculés :

insert into xen_statv2 select * from toto

go

Après quelques itérations on arrive au volume voulu :

1> select count(*) from xen_stat_v2

2> go

Temps d'analyse et de compilation 0.

Adaptive Server cpu time: 0 ms.

Temps d'analyse et de compilation 0.

Adaptive Server cpu time: 0 ms.

-----------

13174976

Temps d'execution 18.

Adaptive Server cpu time: 1800 ms. Adaptive Server elapsed time: 22970 ms.

Soit un peu moins de 23 secondes.

La taille atteinte par le "LOG" est assez conséquente, à cause des ordres insert et a nécessité la mise en place d'un log de 1536Mo pour que le dernier ordre "insert" atteigne la fin,. On a quand même inséré plus de 6,5 millions de lignes.

Le volume occupé par la table et ses deux index est d'environ 2200Mo.

Résultats du mini test.

- Test 1 création de deux index :

Adaptive Server cpu time: 287300 ms. Adaptive Server elapsed time: 417160 ms.

Adaptive Server cpu time: 240100 ms. Adaptive Server elapsed time: 400633 ms.

Soit un total de #818 secondes ou 13'38 ".

- Test 2 re-calcul des statistiques :

update statistics MABASE.dbo.xen_stat_v2

go

Adaptive Server cpu time: 0 ms. Adaptive Server elapsed time: 165280 ms.

Le CPU est à >98% durant tout le calcul qui dure 1'45".

- Test 3 quelques "select" :

a) select DOMNOM,count(*) from xen_stat_v2 group by DOMNOM order by DOMNOM

go

- passe 1 : Adaptive Server cpu time: 0 ms. Adaptive Server elapsed time: 35983 ms

- passe 2 : Adaptive Server cpu time: 0 ms. Adaptive Server elapsed time: 34093 ms.

Soit #35 secondes

b) select DOMNOM,count(*) from xen_stat_v2 group by DOMNOM order by DOMNOM

go

- passe 1 : Adaptive Server cpu time: 28900 ms. Adaptive Server elapsed time: 88873 ms.

- passe 2 : Adaptive Server cpu time: 0 ms. Adaptive Server elapsed time: 81843 ms.

Soit #85 secondes

Sur ces deux tests le CPU monte à plus de 98%

Clickhouse : une performance étonnante

Clickhouse : une performance étonnante jppJ'ai découvert, un peu par hasard, l'existence de cette base de données, c'est dans l'interface de Ntopng que j'ai vu que l'enregistrement des données dans Mysql était "deprecated" et ne serait pas poursuivi dans la prochaine version.

C'est un peu dommage car MariaDB/Mysql est un standard incontournable, mais Clickhouse semble néanmoins présenter quelques avantages, notamment au niveau de la performance.

J'ai donc décidé de voir un peu les caractéristiques de cette base Clickhouse.

Ce groupe d'article présente, un peu, les caractéristiques de cette nouvelle base au moins au niveau des performances.

Clickhouse propose deux "consoles" sur deux ports différents :

- Une à la syntaxe Clickhouse parfois un peu particulière.

- Une à la syntaxe MariaDB/Mysql qui permet un abord plus immédiat.

La plupart des tests réalisés dans ce groupe d'articles ont été réalisés avec la console "Mysql".

Clickhouse : installation

Clickhouse : installation drupadminIl existe un dépôt pour Debian 11 géré directement par Clickhouse, l'installation sera donc simple.

Afin de ne pas risquer de "polluer" une machine existante j'ai décidé d'installer une machine virtuelle KVM munie d'un "gros" disque car j'avais dans l'idée d'y charger une grosse table, (justement mes archives de Ntopng) qui fait plus de 600 millions de rangs (6 ans d'archives).

La machine comportait au démarrage :

CPU : 4 VCPU

Disque : #400Go

RAM = 6 Go

Ajouter la clef GPG de clickhouse (en root) :

apt-key adv --keyserver hkp://keyserver.ubuntu.com:80 --recv 8919F6BD2B48D754

Ajouter un fichier "clickhouse.list" dans /etc/apt/sources.list.d contenant :

deb https://packages.clickhouse.com/deb stable main

Il suffira alors d'un "apt update" et tout sera prêt pour lancer l'installation :

apt install --force-overwrite clickhouse-client clickhouse clickhouse-common clickhouse-common-static clickhouse-server clickhouse-tools

Note : J'ai été obligé d'utiliser --forcce-overwrite à cause du paquet clickhouse-tools.

L'installation s'est bien passée et tout a fonctionné rapidement, le fichier "service" pour systemd est bien sûr disponible. Le serveur dispose de plusieurs ports dédiés à :

Port natif

Port Mysql like

Port Postgresql like

Il est ainsi possible d'utiliser une syntaxe connue telle de Mysql/MariaDB ou Postgresql.

Je me suis concentré sur la syntaxe Mysql que je connais mieux que celle de Postgres. J'ai donc pu créer rapidement un utilisateur dédié, les bases de données et les tables dont j'avais besoin.

On peut même créer une base "virtuelle" reliée directement à une base Mysql/MariaDB.

Mon seul problème a été la taille de RAM allouée à cette machine, les 6Go se sont vite avérés insuffisants, le chargement des données ne dépassait pas 100 millions de rangs ...

Après quelques tâtonnements j'ai vu qu'il ne fallait pas être avare avec la RAM pour obtenir un fonctionnement sans plantage. Lors des chargements de données des "Segmentation fault" et lors de l'exécution d'ordres SQL des plantages pour "(MEMORY_LIMIT_EXCEEDED)".

j'ai donc, par paliers, augmenté la RAM jusqu'à un fonctionnement impeccable obtenu dès 24Go que j'ai un peu poussé à 28Go pour pouvoir charger sans problèmes ma "grosse" table.

28 Go cela fait déjà une jolie VM heureusement que la machine "support" dispose de 64Go !

Clickhouse : premier contact

Clickhouse : premier contact jppJ'ai lu quelques doc, mais ce qui m'a intéressé c'est la compatibilité avec la syntaxe Mysql.

Pour l'utiliser pleinement il suffit de connecter son client mysql favori (a installer si besoin) sur le port 9004. Je me suis alors retrouvé dans un environnement "connu" qui m'a permis de faire les premières manips.

Créer une nouvelle base de données : "CREATE DATABASE toto;"

Aller voir dans cette base : "use toto;"

Créer un utilisateur avec les droits d'administration :

create user administrateur identified by 'le_mot_de_passe_qui_tue';

grant all on *.* to administrateur;

Par contre pour créer une table il faut se plier à la syntaxe "locale", les types ne sont pas tout à fait les mêmes et il faut un peu "ruser".

Le "CREATE TABLE" n'offre aucun mystère.

Pour le "ENGINE" à utiliser il y en a plusieurs j'ai utilisé le plus "simple" : "MergeTree" avec les majuscules pour lequel il faut préciser un "order by xxx" et éventuellement un partitionnement.

Je n'ai pas testé le partitionnement, pas encore ...

Pour les champs numériques : int16,int32,int64; UInt16, UInt32 ...

Pour les champs date : Datetime fonctionne bien

Pour les champs alphanumériques : String.

Ne pas oublier de préciser "Nullable(type)" pour les champs qui peuvent prendre la valeur NULL.

En ce qui concerne les fonctions (par exemple celles sur les dates) la syntaxe est, malheureusement, différente de celle proposée par Mysql/MariaDB.

Une fonction particulièrement intéressante pour communiquer avec des bases Mysql/MariaDB est la possibilité de création de bases "distantes". Cette possibilité est analogue aux fonctionnalités accessibles à l'aide du module "federated" de MariaDB.

Il devient ainsi possible de récupérer directement dans Clickhouse des données d'une base extérieure. C'est cette fonctionnalité que j'ai utilisée pour importer la grosse table destinée aux essais.

La syntaxe est très simple (connexion sur le port "Mysql" :

CREATE TABLE toto as select * from base_distante.table.

Clickhouse : charger table test

Clickhouse : charger table test jppLe chargement de la table va être possible en utilisant des ordres SQL (syntaxe Mysql) avec :

- Création d'une base distante

- Création d'une table locale

- Insertion dans la table locale des rangs de la table distante.

La création d'une base distante possède une syntaxe proche de celle utilisée par les tables "federated" :

CREATE DATABASE base_distante

ENGINE = MySQL('IP:3306',

'nom_base_distante',

'user distant', 'mot_de_passe_distant')

SETTINGS read_write_timeout=10000, connect_timeout=10;

Il est alors possible de faire un "SELECT" sur la base distante.

La recopie d'une table devient :

insert into base_locale.nom_table

select * from base_distante.nom_table

where idx > 0 ;

Pour une table volumineuse le temps peut être assez important. Dans mon cas le transfert entre la MV et la machine physique atteignait 130Mo/seconde et le temps total de chargement de plus de 500 millions de rangs a duré un peu moins d'une heure.

Dans la base MariaDB cette table utilise environ 300GO, Dans la base Clickhouse le volume est d'un peu plus de 140GO. Visiblement la compression semble bien fonctionner.

Clickhouse : Test 1

Clickhouse : Test 1 jppPour ce premier test sur cette "grosse" table j'ai repris un ordre SQL dont je m'étais servi pour repérer les plus gros scanneurs. Je rappelle que cette table contient des données enregistrées par Ntopng sur ma machine "pont" vers Internet. Et les scans de port sont extrêmement courants, chaque machine connectée à Internet en subit plusieurs centaines par jour.

Cet ordre examine toutes les données d'entrée qui n'ont donné lieu à aucune réponse (port fermé ou IP bloquée par le firewall) la sortie est limitée aux 20 plus "gros scanneurs".

select IP_SRC_ADDR as IP_V4,count(*) as CTR,

count(distinct L4_DST_PORT) as NBPORTS,

min(FIRST_SWITCHED) as DEBUT,max(LAST_SWITCHED) as FIN

from flowsv4

where IP_SRC_ADDR not between '192.158.1.1' and '192.168.3.255'

and OUT_BYTES = 0

group by 1

order by 2 desc

limit 20;

Et voici les résulats :

1) Pour Clickhouse :

| ┌─IP_V4───────────┬────CTR─┬─NBPORTS─┬───────────────DEBUT─┬─────────────────FIN─┐ │ 0.0.0.0 │ 133379 │ 2 │ 2016-08-02 21:20:07 │ 2022-08-27 00:13:06 │ │ 45.143.220.101 │ 80996 │ 64408 │ 2020-03-22 22:19:49 │ 2020-04-17 02:14:24 │ │ 92.63.197.23 │ 65295 │ 65295 │ 2021-09-17 22:38:39 │ 2021-09-24 05:22:53 │ │ 45.143.200.34 │ 46036 │ 25699 │ 2021-04-09 23:14:37 │ 2022-02-10 21:25:53 │ │ 173.231.60.195 │ 44355 │ 2 │ 2021-12-09 06:09:06 │ 2022-03-09 13:07:02 │ │ 92.63.197.108 │ 38179 │ 32243 │ 2021-08-22 13:29:04 │ 2021-11-25 04:31:09 │ │ 146.88.240.4 │ 37229 │ 63 │ 2019-04-11 04:59:05 │ 2022-08-26 06:02:19 │ │ 92.63.197.112 │ 36060 │ 32081 │ 2021-08-22 13:27:51 │ 2021-11-25 10:31:34 │ │ 92.63.197.110 │ 35671 │ 29999 │ 2021-08-22 13:29:24 │ 2022-07-10 12:52:55 │ │ 212.70.149.69 │ 35319 │ 1 │ 2020-10-19 04:34:22 │ 2020-12-18 12:52:19 │ │ 10.128.175.2 │ 33844 │ 1 │ 2018-06-02 05:03:16 │ 2020-07-01 12:23:01 │ │ 176.113.115.246 │ 33618 │ 32906 │ 2020-01-29 09:24:25 │ 2020-05-09 20:52:01 │ │ 212.70.149.68 │ 32400 │ 1 │ 2020-08-21 04:34:36 │ 2020-10-16 20:38:35 │ │ 185.176.27.2 │ 32322 │ 22565 │ 2018-12-06 17:13:49 │ 2020-08-12 23:43:46 │ │ 92.154.95.236 │ 31960 │ 1092 │ 2017-12-07 23:05:08 │ 2021-12-13 13:30:54 │ │ 185.156.73.91 │ 31756 │ 20609 │ 2020-10-04 03:09:37 │ 2022-08-26 23:44:13 │ │ 185.156.73.107 │ 31625 │ 25338 │ 2021-06-19 09:04:14 │ 2022-02-13 12:30:53 │ │ 195.54.166.93 │ 31183 │ 29850 │ 2020-01-15 21:46:51 │ 2020-02-17 05:38:35 │ │ 51.68.126.248 │ 30228 │ 4 │ 2020-02-25 22:40:19 │ 2020-04-06 01:24:36 │ │ 92.63.197.105 │ 29300 │ 16042 │ 2021-05-16 17:24:56 │ 2021-12-07 23:21:30 │ └─────────────────┴────────┴─────────┴─────────────────────┴─────────────────────┘ 20 rows in set. Elapsed: 6.138 sec. Processed 488.52 million rows, 18.98 GB (79.59 million rows/s., 3.09 GB/s.) |

2) Pour MariaDB :

| +-----------------+--------+---------+---------------------+---------------------+ | IP_V4 | CTR | NBPORTS | DEBUT | FIN | +-----------------+--------+---------+---------------------+---------------------+ | 0.0.0.0 | 133379 | 2 | 2016-08-02 21:20:07 | 2022-08-27 00:13:06 | | 45.143.220.101 | 80996 | 64408 | 2020-03-22 22:19:49 | 2020-04-17 02:14:24 | | 92.63.197.23 | 65295 | 65295 | 2021-09-17 22:38:39 | 2021-09-24 05:22:53 | | 45.143.200.34 | 46036 | 25699 | 2021-04-09 23:14:37 | 2022-02-10 21:25:53 | | 173.231.60.195 | 44355 | 2 | 2021-12-09 06:09:06 | 2022-03-09 13:07:02 | | 92.63.197.108 | 38179 | 32243 | 2021-08-22 13:29:04 | 2021-11-25 04:31:09 | | 146.88.240.4 | 37229 | 63 | 2019-04-11 04:59:05 | 2022-08-26 06:02:19 | | 92.63.197.112 | 36060 | 32081 | 2021-08-22 13:27:51 | 2021-11-25 10:31:34 | | 92.63.197.110 | 35671 | 29999 | 2021-08-22 13:29:24 | 2022-07-10 12:52:55 | | 212.70.149.69 | 35319 | 1 | 2020-10-19 04:34:22 | 2020-12-18 12:52:19 | | 10.128.175.2 | 33844 | 1 | 2018-06-02 05:03:16 | 2020-07-01 12:23:01 | | 176.113.115.246 | 33618 | 32906 | 2020-01-29 09:24:25 | 2020-05-09 20:52:01 | | 212.70.149.68 | 32400 | 1 | 2020-08-21 04:34:36 | 2020-10-16 20:38:35 | | 185.176.27.2 | 32322 | 22565 | 2018-12-06 17:13:49 | 2020-08-12 23:43:46 | | 92.154.95.236 | 31960 | 1092 | 2017-12-07 23:05:08 | 2021-12-13 13:30:54 | | 185.156.73.91 | 31756 | 20609 | 2020-10-04 03:09:37 | 2022-08-26 23:44:13 | | 185.156.73.107 | 31625 | 25338 | 2021-06-19 09:04:14 | 2022-02-13 12:30:53 | | 195.54.166.93 | 31183 | 29850 | 2020-01-15 21:46:51 | 2020-02-17 05:38:35 | | 51.68.126.248 | 30228 | 4 | 2020-02-25 22:40:19 | 2020-04-06 01:24:36 | | 92.63.197.105 | 29300 | 16042 | 2021-05-16 17:24:56 | 2021-12-07 23:21:30 | +-----------------+--------+---------+---------------------+---------------------+ 20 rows in set (12 min 56,412 sec) |

3) Comparaison.

Les résultats sont identiques ce qui est très bien !

La comparaison est impressionnante : 6 secondes au lieu de 776 soit quasiment 130 fois plus vite !

On voit aussi que l'adresse IP 45.143.220.101 a scanné quasiment l'intégralité des ports existants en un peu moins d'un mois (scan "lent") ou que l'IP 173.231.60.195 ne scanne que deux ports mais a effectué plus de 40000 connexions en un peu moins d'un an, cela fait quand même plus de 100 par jour.

Clickhouse : Test 2

Clickhouse : Test 2 jppCet ordre SQL devait me permettre de voir s'il y avait des trous de numérotation dans les valeurs du champ "idx".

Il m'a valu de nombreux ennuis avant que la mémoire ne soir "gonflée" avec de méchants messages :

Received exception from server (version 22.8.2):

Code: 241. DB::Exception: Received from localhost:9000. DB::Exception: Memory limit (total) exceeded: would use 3.73 GiB (attempt to allocate chunk of 537537181 bytes), maximum: 3.48 GiB. OvercommitTracker decision: Query was selected to stop by OvercommitTracker.: While executing AggregatingTransform. (MEMORY_LIMIT_EXCEEDED)

L'ordre est très simple :

select min(idx),max(idx), count(distinct idx) from flowsv4;

Dès que la RAM a été "suffisante" (plus de 24Go de RAM) ces messages ont disparu et les résultats sont là et bien là.

1) Résultats Clickhouse.

┌─min(idx)─┬──max(idx)─┬─uniqExact(idx)─┐

│ 1 │ 488553902 │ 488521496 │

└──────────┴───────────┴────────────────┘

1 row in set. Elapsed: 27.822 sec. Processed 488.52 million rows, 3.91 GB (17.56 million rows/s., 140.47 MB/s.)

2) Résultats MariaDB.

+----------+-----------+---------------------+

| min(idx) | max(idx) | count(distinct idx) |

+----------+-----------+---------------------+

| 1 | 488553902 | 488521496 |

+----------+-----------+---------------------+

1 row in set (5 min 42,522 sec)

3) Résultat final.

27 secondes contre 342 soit environ 13 fois plus vite.

Clickhouse : Test 3

Clickhouse : Test 3 jppLe but de cet ordre SQL est de trouver les adresses IP qui ont contacté sans succès la machine, ceci est identifié par une valeur 0 dans le champ OUT_BYTES et qui ont "tenté" des connexions sur au moins 10 ports différents. Ceci peut arriver si la demande a été bloquée par le firewall (drop).

L'ordre SQL est légèrement différent car les fonctions de gestion des dates ont des syntaxes légèrement différentes.

| select IP_SRC_ADDR as SRC,IP_DST_ADDR as DST, count(distinct L4_DST_PORT) as NPORT from flowsv4 -- mariadb where FIRST_SWITCHED > DATE_SUB(now(), interval 20 day) -- clickhouse where FIRST_SWITCHED > DATE_SUB(DAY,20,now()) and IP_SRC_ADDR not between '192.168.1.1' and '192.168.3.255' and L4_DST_PORT < 15000 group by SRC,DST having NPORT > 10 order by SRC; |

La différence n'est pas énorme mais il faut y faire attention ...

Et maintenant passons aux faits.

1) Clickhouse.

| ┌─SRC─────────────┬─DST─────────┬─NPORT─┐ │ 103.138.109.220 │ 192.168.1.2 │ 105 │ │ 103.56.61.144 │ 192.168.1.2 │ 12 │ │ 104.156.155.13 │ 192.168.1.2 │ 1216 │ │ 104.168.53.114 │ 192.168.1.2 │ 23 │ ...... │ 94.232.45.241 │ 192.168.1.2 │ 68 │ │ 95.161.131.235 │ 192.168.1.2 │ 19 │ └─────────────────┴─────────────┴───────┘ 377 rows in set. Elapsed: 0.120 sec. Processed 7.92 million rows, 395.57 MB (66.10 million rows/s., 3.30 GB/s.) |

2) MariaDB.

| +-----------------+-------------+-------+ | SRC | DST | NPORT | +-----------------+-------------+-------+ | 103.138.109.220 | 192.168.1.2 | 105 | | 103.56.61.144 | 192.168.1.2 | 12 | | 104.156.155.13 | 192.168.1.2 | 1216 | | 104.168.53.114 | 192.168.1.2 | 23 | ...... | 94.232.45.241 | 192.168.1.2 | 68 | | 95.161.131.235 | 192.168.1.2 | 19 | +-----------------+-------------+-------+ 377 rows in set (19,137 sec) |

3) Comparaison.

Le rapport entre 19 secondes et 0.12 est frappant, Clickhouse est 158 fois plus rapide.

Clickhouse : Test 4

Clickhouse : Test 4 jppCet ordre SQL est très simple et le résultat est plus que spectaculaire, le passage "Clickhouse" a été réalisé avec l'interface compatible Mysql.

L'ordre est très simple :

select count(*),max(LAST_SWITCHED),max(FIRST_SWITCHED) from flowsv4;1) Résultats Clickhouse.

+-----------+---------------------+---------------------+

| count() | max(LAST_SWITCHED) | max(FIRST_SWITCHED) |

+-----------+---------------------+---------------------+

| 521129534 | 2022-11-17 23:35:18 | 2022-11-17 23:35:18 |

+-----------+---------------------+---------------------+

1 row in set (1.863 sec)

2) Résultats MariaDB.

+-----------+--------------------+---------------------+

| count(*) | max(LAST_SWITCHED) | max(FIRST_SWITCHED) |

+-----------+--------------------+---------------------+

| 521129338 | 1668724485 | 1668724485 |

+-----------+--------------------+---------------------+

1 row in set (13 min 40,620 sec)3) Résultat final.

1,85 secondes pour Clickhouse contre 820 pour MariaDB soit environ 440 fois plus vite !

Clickhouse : Test 5

Clickhouse : Test 5 jppJ'ai voulu faire un dernier test qui représente un gros travail toujours à partir de la même table qui atteint maintenant 542 975 185 rangs ce qui représente un bon test.