ZIMBRA : Phase 3 : l'aspect

ZIMBRA : Phase 3 : l'aspect jppL'installation est faite, la machine a redémarré, admirons un peu le résultat.Permière constation : il y a plein de ports utilisés ( lsof -Pn | grep TCP ): 25, 80, 110, 143, 389, 993, 3310, 5222, 5223, 7110, 7143, 7777, 7780, 10024 et j'en oublie ...

Cela va être un peu coton de s'y retrouver.

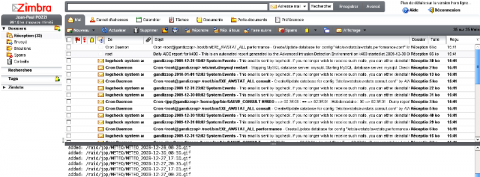

Le port 80 donne accès au WebMail, dont voici un premier aperçu :

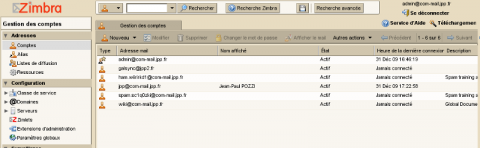

Le port 7071 (en https) donne accès à l'interface d'administration dont voici un aperçu :

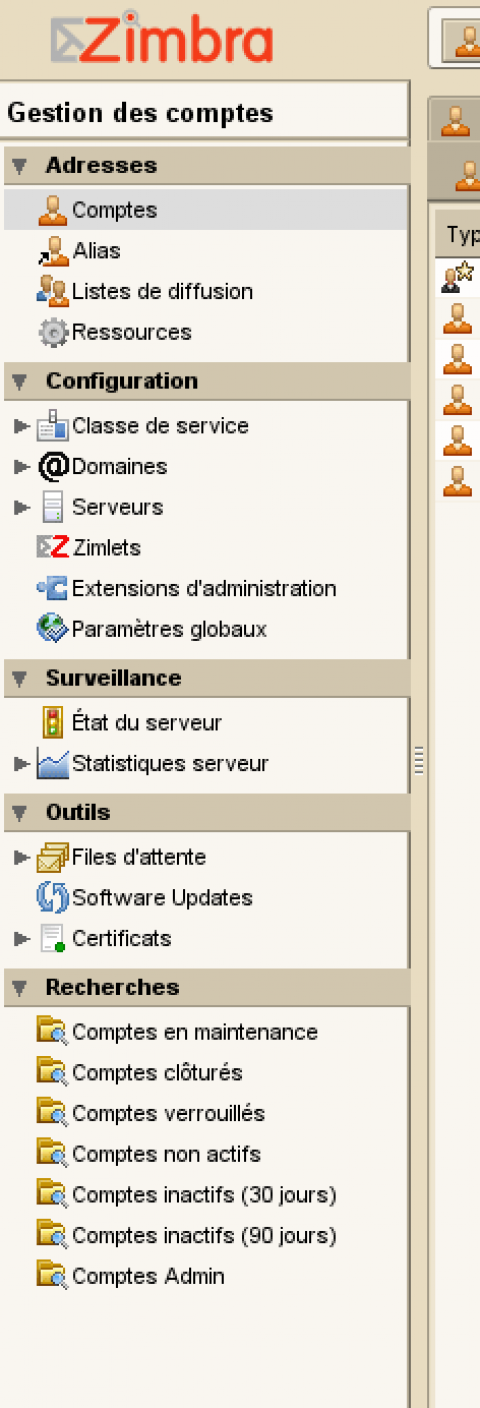

Le menu d'administration se présente de la façon suivante :

Sont présentés ici :

- La gestion des comptes

- La gestion des Alias

- La gestion des listes de diffusion

- La gestion des classes de service, elle permet de créer des standards à appliquer aux utilisateurs (notion de "groupes") qui simplifie la gestion des utilisateurs.

- La dernière partie présente des vues spécifiques des comptes ouverts.

En bref c'est très complet mais il y a pas mal de boulot avant de savoir se servir correctement de toutes les fonctions présentes. - La création de multiples "domaines" virtuels, le serveur est ainsi capable de servir plusieurs domaines différents

D'autres éléments que je n'ai pas encore eu le temps d'apprécier :

les Zimlets, les extensions d'administration.

Le menu "Paramètres Globaux" permet de régler finement un grand nombre d'options des différents logiciels, par exemple les paramètres de Postfix.

L'état du serveur présente la liste de l'état des différents services.

De même le serveur maintient des statistiques d'usage (CPU, IO, nombre de mails, nombre de spam, nombre de virus détectés ....

Les outils permettent de surveiller l'état des files d'attente, de paramétrer la recherche des mises à jour, la gestion de certificats ....